Здравствуйте, друзья! Хотите получить хорошую позицию в выдаче поисковых систем? Тогда вам нужно подойти более ответственно к вашему SEO. А я вам помогу. Сегодня мы с вами рассмотрим - самые распространённые SEO-ошибки сайтов на CMS WordPress. Использование движка WordPress даёт вам большое преимущество. В популярной CMS есть все базовые возможности для правильной настройки SEO. Используйте их.

WordPress по праву считается одной из самых SEO-дружественных платформ для создания сайта: она имеет ряд функций и характеристик, которые помогают адаптировать ресурс согласно рекомендациям поисковых систем даже без помощи разработчиков. Однако далеко не все владельцы оптимизируют свои сайты под SEO, из-за чего пробиться в ТОП-10 выдачи и выдержать конкуренцию очень сложно. Вебмастера допускают следующие SEO-ошибки на своих сайтах.

SEO-ошибки на сайтах WordPress

В этой статье мы разберём самые частые SEO-ошибки и упущения начинающих блогеров в оптимизации сайтов.

Не оптимизированные URL-адреса

Автоматическая генерация URL в WordPress облегчает работу и позволяет экономить время. Но не правильно настроив генерацию, вы рискуете получить множество нелогичных адресов, состоящих из беспорядочного набора символов. Такие URL являются не информативными и затрудняют навигацию, а это, в свою очередь, отрицательно влияет на поведенческие факторы. К тому же оптимизированные URL давно стали одним из факторов ранжирования большинства поисковых систем.

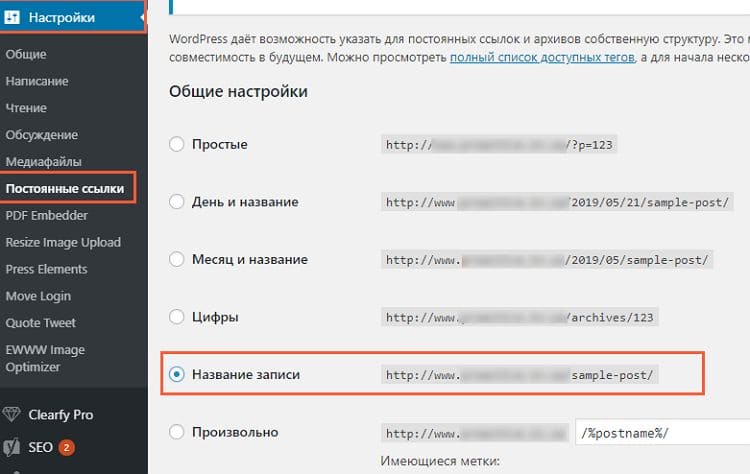

Чтобы ваши URL были читабельными, настройте генерацию URL по названию постов. Для этого в разделе "Настройки" → "Постоянные ссылки" отметьте пункт "Название записи".

Оптимизировать URL необходимо сразу после установки ВордПресс. Но даже после этой настройки проверяйте каждый URL на уникальность (в рамках сайта) и соответствие ЧПУ.

По возможности укорачивайте URL — так они выглядят привлекательнее, за счёт чего могут способствовать повышению рейтинга кликов. Желательно также, чтобы при этом в URL содержалось ключевое слово.

Важно: если вы используете форматы ссылок "день и название" или "месяц и название" более полугода, не меняйте в настройках структуру постоянных ссылок, так как это может спровоцировать снижение рейтинга.

Отсутствие или неправильная настройка файла robots.txt

Для корректной и быстрой индексации сайта поисковыми роботами очень важно правильно настроить файл robots.txt и следить, чтобы в нём не было допущено ошибок, особенно:

- Ошибок в синтаксисе;

- Ошибок в директивах;

- Закрытие доступа к сканированию важной части контента сайта;

- Блокировки файлов изображений и CSS.

Чтобы избежать ошибок в написании директив и синтаксиса, ознакомьтесь со справкой Google и Яндекс, где подробно описана специфика файла. А плагины WP Robots Txt и Yoast SEO помогут вам в быстрой и автоматической генерации файла robots.txt.

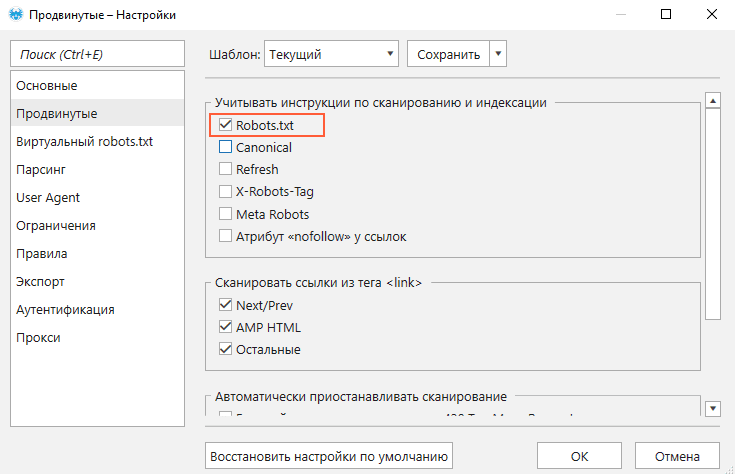

Проверить, какие страницы закрыты или открыты в уже существующем robots.txt, вы можете с помощью специальных программ. Например, краулера . Из главного окна программы перейдите в "Настройки" → "Продвинутые". В разделе "Учитывать инструкции по сканированию и индексации" отметьте пункт "Robots.txt".

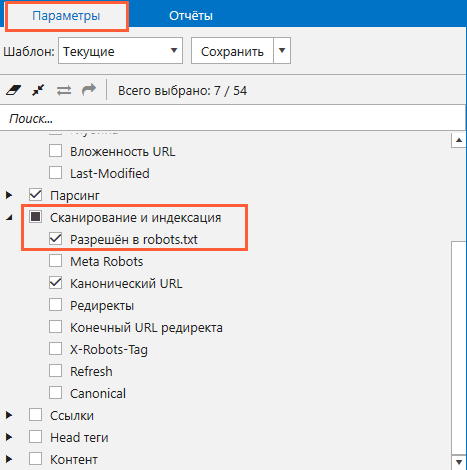

Сохраните настройки. На боковой панели на вкладке "Параметры" отметьте "Разрешён в robots.txt".

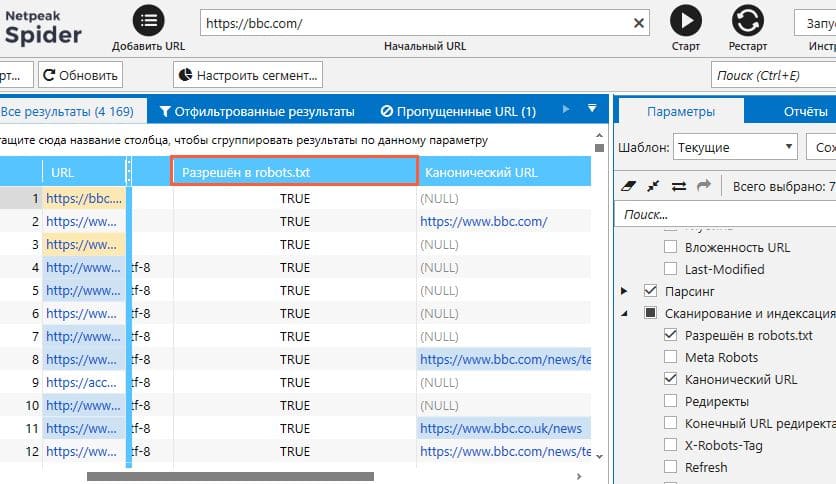

Вставьте главный домен сайта в верхнюю строку и нажмите "Старт".

По завершении сканирования в окне "Все результаты" ознакомьтесь с колонкой "Разрешён в robots.txt", где значение TRUE означает, что страница открыта к индексации, а FALSE — закрыта.

Также закрытые от индексации и сканирования страницы попадут во вкладку "Пропущенные URL".

Отсутствие XML-карты сайта

Ухудшение индексации может быть вызвано не только ошибками в файле robots,txt, но также отсутствием XML-карты сайта.

XML-карта сайта (файл Sitemap) - это документ, который сообщает поисковым системам о страницах сайта, доступных для индексации.

C автоматическим созданием файла XML Sitemap отлично справляется WordPress плагин Google Sitemap Generator.

Также для создание XML карты сайта можно использовать SEO плагин Yoast SEO, Rank Math или All in One SEO Pack.

Не оптимизированные мета-теги

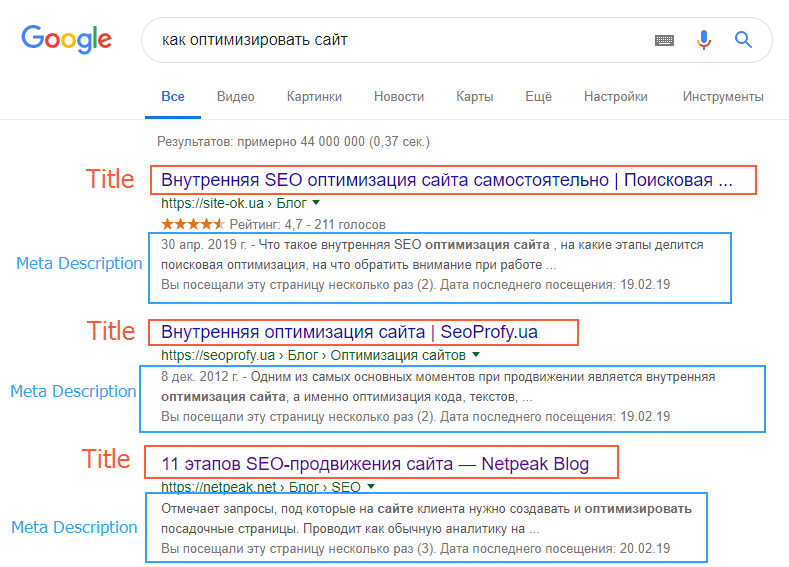

Мета-тег Description и тег Title очень важны для сайта, так как именно их видит пользователь в результатах выдачи, когда ищет нужную информацию.

Description - Предназначен для предоставления поисковым системам краткого описания содержимого страницы для индексации и вывода сопроводительной информации в выдаче результатов поиска.

Заголовок (Title) - это один из самых важных факторов оптимизации страницы. Именно заголовок первым видит посетитель поисковой системы в органической выдаче. Именно Title он первым оценивает и принимает решение перейти или нет на ваш сайт.

Для настройки тегов Title и мета описания воспользуйтесь плагином WordPress Yoast SEO. Но перед этим ознакомьтесь с требованиями по их составлению, так как неправильно составленные Title и Description могут навредить продвижению сайта.

Как правильно составить Title

- Коротко и понятно передать в нём содержимое страницы;

- Стараться не превышать длину в 70 символов (с пробелами);

- Включить минимум один высокочастотный запрос;

- Сделать его уникальным для каждой отдельной страницы.

Как составить правильный Meta Description

- Придерживаться оптимальной длины — от 60 до 320 символов;

- Сделать его уникальным для каждой страницы;

- Добавить ключевое слово.

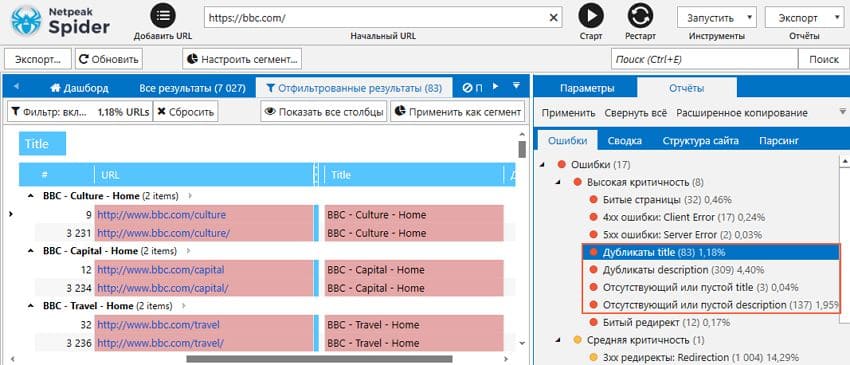

Сделать проверку Title и мета описания страниц на сайте вы можете также в краулере Netpeak Spider, который определяет:

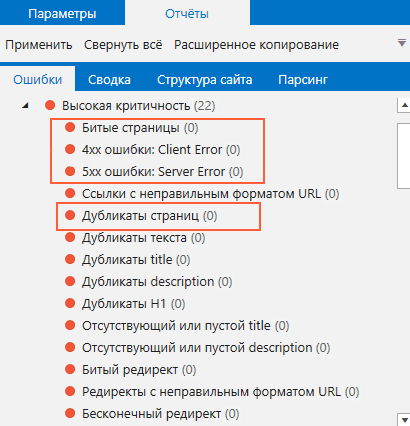

- Дубликаты Title и Description;

- Страницы, где нет Title и Description;

- Слишком короткие или слишком длинные Title и Description.

Как проверить:

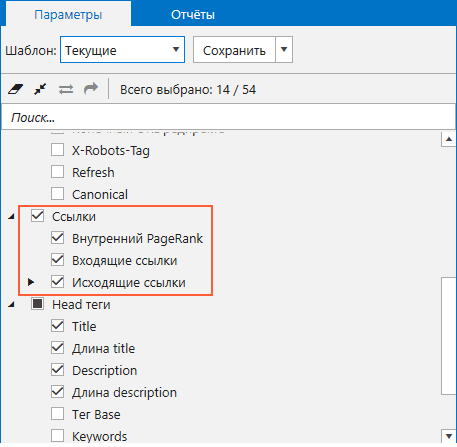

- На вкладке "Параметры" боковой панели программы в разделе "Head теги" отметьте нужные параметры.

- Запустите сканирование.

- После его окончания на боковой панели ознакомьтесь с найденными ошибками.

Не оптимизированные изображения

Изображения положительно влияют на восприятие контента и способствуют притоку дополнительно трафика. И чтобы изображения не утяжеляли страницу (скорость загрузки сайта) и хорошо ранжировались в поиске, их необходимо оптимизировать.

Изображения - это именно те ресурсы, которые занимают много места на странице и весят больше всего. Благодаря их оптимизации мы можем

значительно уменьшить количество скачиваемых данных и улучшить работу сайта.

Для изображений следующие требования:

- Задайте единый размер изображений для всего сайта и придерживайтесь его.

- Сжимайте изображения с помощью программ или специальных сервисов (Compressor, TinyJPG, TinyPNG, ImageOptim), чтобы ускорить загрузку страницы.

- Прописывайте атрибут ALT. С его помощью поисковым роботам будет проще определить содержимое изображения, а пользователям — найти его в поиске по картинкам.

- Давайте понятные и читабельные названия файлам изображений.

Отсутствие внутренних ссылок (Внутренняя перелинковка)

Внутренние ссылки на страницах облегчают навигацию, передают вес, тем самым помогая улучшить продвижение страниц.

Перелинковкой сайта (от английского "link") называют связывание страниц одного сайта или разных ресурсов гиперссылками.

Перелинковка разделяется на внешнюю и внутреннюю.

Количество ссылок с других страниц сайта говорит поисковым системам, насколько данная страница ценна, по сравнению с иными страницами. А использование анкорных ссылок показывает, как минимум, тематику страницы - акцептора, переносят на нее релевантность. Поэтому, контекстные ссылки из текста страницы более ценны для ПС, чем ссылки из меню.

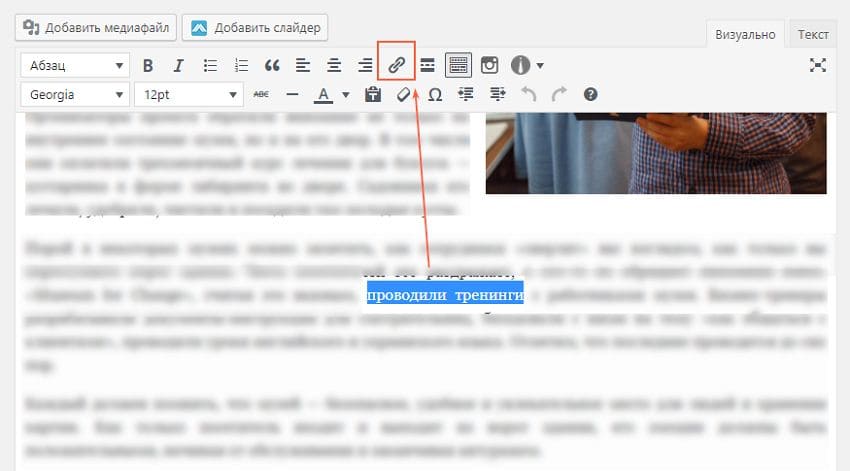

И как обычно, важны не только слова запроса, но и их синонимы. Разместить внутренние контекстные ссылки в WordPress очень просто:

- В текстовом редакторе выделите слово или фразу, которая будет служить анкором.

- Затем нажмите на иконку "Вставить ссылку".

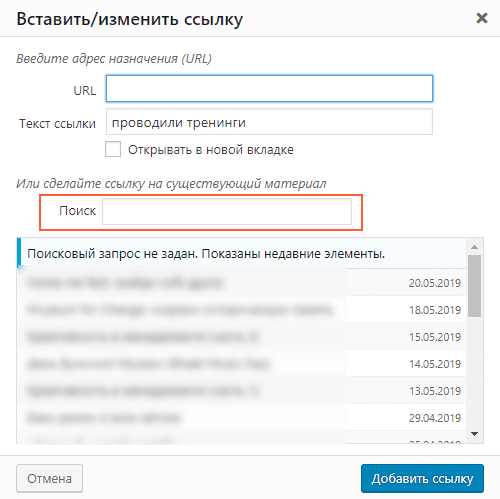

3. Укажите URL страницы, на которую вы будете ссылаться.

4. Открыв настройки, вы можете воспользоваться поиском, чтобы найти релевантные страницы. После того, как вы указали URL, нажмите "Добавить ссылку".

При проставлении внутренних ссылок важно учитывать следующие моменты:

- Анкор должен передавать тематику страницы, на которую вы ссылаетесь.

- Ссылка должна вести на работающую страницу и содержать релевантный контент.

- Ссылаться можно на определённую страницу только один раз в рамках конкретной статьи.

Найти страницы, на которых нет исходящих внутренних ссылок, вы можете в Netpeak Spider. Для этого:

- Отметьте пункт "Ссылки" в разделе параметры.

2. Просканируйте сайт.

3. В отчёте "Ошибки" обратите внимание на наличие ошибок "PageRank: отсутствуют связи" и "PageRank: отсутствуют исходящие ссылки".

Кликните на каждую, чтобы ознакомиться со списком URL, которые не содержат внутренних ссылок.

Попадание неважных для продвижения страниц в индекс

Иногда страницы, не участвующие в продвижении, например, страницы в процессе разработки или страницы печати, попадают в поисковую выдачу. Это происходит потому, что у роботов поисковых систем есть к ним доступ. Удалить страницы из индекса можно с помощью специальных инструментов Яндекс и Google.

Чтобы впредь такие страницы не попадали в выдачу, закройте роботам доступ с помощью Meta Robots или HTTP-заголовка X-Robots-Tag. Узнать, как правильно это сделать, вы можете на основе информации в справках поисковых систем: Google и Яндекс.

Игнорирование мусорных страниц

В предыдущем пункте речь шла о страницах, имеющих определённую ценность, но появление которых в индексе и поисковой выдаче нежелательно. Но, на сайте могут появляться и бесполезные, так называемые, «мусорные» страницы: дубликаты, битые страницы и пустые страницы без контента.

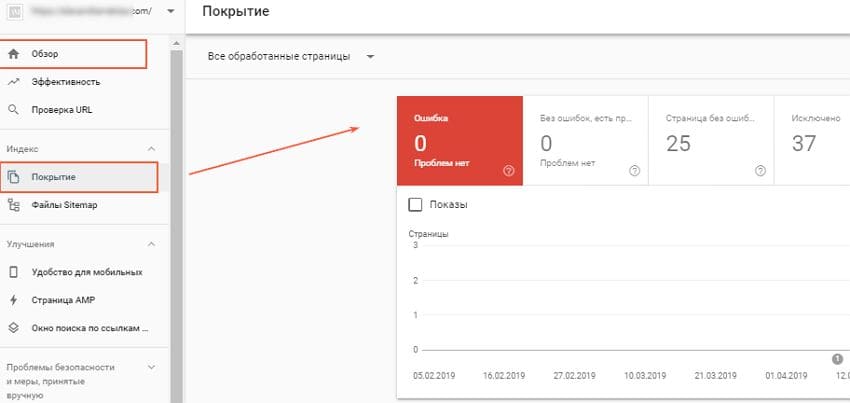

Чтобы проверить, есть ли такие страницы на вашем сайте, вы можете воспользоваться:

1. Сервисом Google Search Console.

2. Сервисом Яндекс.Вебмастер.

3. Краулером Netpeak Spider.

Если на сайте были обнаружены проблемные страницы, от них необходимо избавиться.

Дубликаты вы можете устранить такими способами:

- Настроить редирект на основную страницу;

- Удалить страницу и настроить 404 код ответа сервера, но предварительно снять все ссылки, которые вели на эту страницу;

- С помощью тега rel="canonical" указать URL основной страницы, которой стоит передавать ссылочный вес.

Чтобы избавиться от битых страниц, удалите все ссылки, которые вели на них и займитесь красивым оформлением страницы 404, чтобы минимизировать показатель отказов.

Пустые же страницы можно наполнить качественным контентом или закрыть от индексации.

Не адаптированный под мобильные устройства сайт

Мобильная версия сайта давно стала необходимостью для каждого веб-ресурса, это объясняется просто: число пользователей, предпочитающих выходить в интернет через телефоны и планшеты, растёт с каждым годом. В связи с этим наличие мобильной версии является одним из самых актуальных факторов ранжирования.

Для сайтов на WordPress уже есть несколько плагинов, с помощью которых это можно реализовать быстро и легко: JetPack, WPTouch, WordPress Mobile Pack, Wiziapp, WP Mobile Detector.

В заключение

Каждый владелец сайта заинтересован в том, чтобы его ресурс появлялся в результатах выдачи. Но далеко не каждый исправляет ошибки на нём, а ведь именно они могут мешать продвижению. Чаще всего на сайтах встречаются такие SEO-ошибки:

- Неструктурированные URL-адреса;

- Отсутствие или неправильная настройка файла robots.txt;

- Отсутствие XML-карты;

- Не оптимизированные мета-теги;

- Не оптимизированные изображения;

- Отсутствие внутренних ссылок;

- Попадание неважных для продвижения страниц в индекс;

- Игнорирование мусорных страниц;

- Сайт не адаптированный под мобильные устройства.

Несмотря на то, что представленные SEO-ошибки WordPress могут нести серьёзную опасность сайту, их легко выявить и устранить. Это можно сделать с помощью специальных сервисов, плагинов и программ.

Всего доброго, друзья. До новых встреч. Удачи.

![Разместите Google Analytics локально в WordPress [6 способов]](https://wordpressmania.ru/wp-content/uploads/2021/04/google-analytics-211x150.jpg)